Évaluation multicritères pour les systèmes de recommandation

Tandis que la plupart des systèmes courants de recommandation, se base sur les systèmes de recommandation utilisant un simple critère d’évaluation, beaucoup d’applications commerciales ont commencé à employer des méthodes d’évaluation multicritères. Yahoo! Cinéma demande à ses utilisateurs de fournir quatre critères spécifiques au sujet du film : histoire, interprétation, réalisation, et images ; Zagat fournit trois critères pour évaluer un restaurant : nourriture, décor, et service ; Circuitcity propose quatre critères pour évaluer un article : l’affichage, la performance, la durée de vie de la batterie, et le coût. L’évaluation multicritères est considérée comme une valeur ajoutée aux systèmes courants de recommandation [1].

Références

[1] G. Adomavicius and K. YoungOk, « New Recommendation Techniques for Multicriteria Rating Systems, » Intelligent Systems, vol. 22, pp. 48-55, 2007.

Collecte des préférences

Les systèmes de filtrage présupposent l’existence d’un système de collecte du degré d’appréciation des utilisateurs pour une ressource donnée. En effet, pour caractériser un profil d’utilisateur, la première chose à collecter est l’évaluation d’une ressource donnée faite par un utilisateur : si cette dernière lui a plu, moins plu, ou pas du tout plus. À cet effet, il existe deux approches: demander à l’utilisateur explicitement d’évaluer lui-même les ressources à partir d’une échelle de notes préalablement définie, ou bien inférer automatiquement cette évaluation, grâce aux informations que l’on peut récolter à partir des données du protocole de communication [1].

Évaluations explicites. Les utilisateurs sont obligés de spécifier explicitement leurs préférences pour toutes les ressources. Généralement, les utilisateurs doivent indiquer leur degré d’appréciation sur une échelle de 1 à 5 ou 1 à 7. De récentes études ont mis en évidence l’impact du choix de l’échelle d’évaluation sur la qualité des recommandations [2].

Évaluations implicites. Les évaluations explicites imposent aux utilisateurs des efforts supplémentaires. En conséquence, les utilisateurs tendent souvent à éviter ce fardeau en quittant définitivement le système ou en fournissant des évaluations erronées [2]. À l’opposé, la déduction de ces évaluations par la seule observation du comportement des utilisateurs est beaucoup moins intrusive. Parmi les exemples typiques de ces observations pour des évaluations implicites, on peut citer l’historique d’achat pour Amazon, le temps de lecture pour Usenet News [2], et l’analyse des comportements de navigation sur Internet pour Quickstep [3, 4].

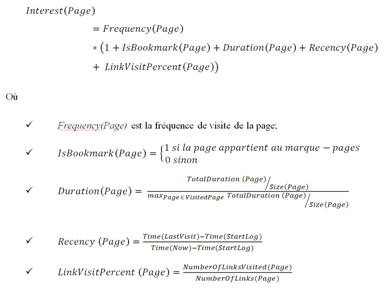

Un exemple réel de l’inférence des évaluations implicite est la formule, proposée par Chan [5], pour prédire si une page web a été appréciée ou pas. Cette formule se base, en grande partie, sur les informations que l’on peut récolter à partir des données du protocole de communication. En effet, elle est calculée en fonction de l’historique, le marque-page (bookmark), le contenu des pages et le journal des accès (« access log »).

Plus précisément, l’historique d’un navigateur web maintient une trace du dernier moment qu’une page a été visitée. On peut donc utiliser cette donnée pour calculer combien de fois un utilisateur passe sur une page et depuis quand il n’est pas retourné la visiter. De plus, on peut également supposer qu’une URL présente dans le marque-page d’un utilisateur est considérée comme intéressante pour celui-ci. En outre, chaque page contient des liens vers d’autres pages. On suppose que si un utilisateur est intéressé par une page, il va probablement visiter les liens référencés par celle-ci. Ainsi, on conjecture qu’un fort pourcentage de liens visités à partir d’une page dénote un intérêt particulier pour cette page. Enfin, chaque entrée dans un journal des accès correspond à une requête HTTP, qui contient typiquement l’adresse IP du client, une marque du moment de connexion, des méthodes d’accès, une URL, un protocole, un statut, et une taille de fichier. Typiquement, une ligne de fichier de log se présente comme suit:

« 216.22.34.11 – – [10/Jul/2008:04:04:54 +0200] « GET /uqam.ca/index.html HTTP/1.1 » 200 2856 »

Où

- 216.22.34.11 correspond à l’adresse IP du client,

- 10/Jul/2008:04:04:54 correspond au moment de connexion,

- GET correspond à la méthode d’accès,

- /uqam.ca/index.html est l’URL de la page qui a été visitée,

- HTTP/1.1 correspond au protocole de communication,

- 200 est la valeur de retour (ici, tout s’est bien passé),

- 2856 correspond à la quantité d’informations transférées (généralement la taille du fichier).

Grâce à ces informations, le temps passé sur chaque page peut être calculé. Cependant, le temps passé sur une page dépendant également de la longueur de cette page, l’intérêt d’un utilisateur pour une page sera calculé par le temps passé sur la page, normalisé par la taille de la page.

Finalement, Chan [5] définit le degré d’intérêt d’une page par:

Un autre exemple concret pour l’évaluation non intrusive est la collecte des préférences des utilisateurs sur la musique écoutée. Les lecteurs multimédias, comme iTunes et Windows Media Player, ont la possibilité d’observer le nombre de fois que vous écoutez une chanson. Ces logiciels peuvent aussi se rappeler la dernière fois que vous avez écouté chaque chanson. Ces informations peuvent être utilisées pour dégager les évaluations implicites des utilisateurs [6]. La figure 1 illustre les différents aspects de notre vie quotidienne qui peuvent être utilisés par les systèmes de recommandations.

Figure 1 Aspects de vie quotidienne pouvant être utilisés par les systèmes de recommandation [6]

Pour conclure, malgré la facilité qu’elle peut apporter dans la collecte des préférences des utilisateurs, l’évaluation implicite comporte quelques limites. Par exemple, les achats faits pour offrir à une autre personne (achats de cadeaux) ou pour le compte de quelqu’un d’autre (achats pour son entreprise) ne reflètent pas les intérêts de l’utilisateur. Ainsi, les évaluations implicites ne représentent pas toujours les préférences réelles de l’utilisateur. De plus, il est difficile d’obtenir des évaluations explicites des utilisateurs. Pour ces raisons, un certain nombre de systèmes de recommandation adoptent des approches hybrides. Amazon.com calcule ses recommandations en se basant, autant que possible, sur des évaluations explicites. En cas d’indisponibilité de ces dernières, des évaluations implicites, inférées des observations des comportements de l’utilisateur, sont utilisées à la place [2].

Références

[1] M. Claypool, M. Claypool, D. Brown, P. Le, and M. A. W. M. Waseda, « Inferring user interest

Inferring user interest, » Internet Computing, IEEE, vol. 5, pp. 32-39, 2001.

[2] C.-N. Ziegler, « Towards Decentralized Recommender Systems, » Albert-Ludwigs-Universitat Freiburg – Fakultat fur Angewandte Wissenschaften, Institut fur Informatik, 2005.

[3] S. E. Middleton, N. R. Shadbolt, and D. C. De Roure, « Ontological user profiling in recommender systems, » ACM Trans. Inf. Syst., vol. 22, pp. 54-88, 2004.

[4] W. Gaul and L. Schmidt-Thieme, « Recommender Systems Based On User Navigation Behaviour In The Internet, » Behaviormetrika, vol. 29, pp. 1-22, 2002.

[5] P. K. Chan, « A non-invasive learning approach to building web user profiles, » Workshop on Web usage analysis and user profiling, Fifth International Conference on Knowledge Discovery and Data Mining, August 1999.

[6] N. B. Miller, « Toward a personal recommender system, » University of Minnesota, 2003, p. 185.